标题:OceanBase发布PowerRAG 、共享存储和桌面版;AWS支持PostgreSQL 18;庆祝MySQL 30活动将与成都举行

重要更新

OceanBase发布PowerRAG 、共享存储和桌面版[1]。其中PowerRAG功能是由OB Cloud上的OceanBase提供的全新功能,支持文档存储、分片到向量检索等功能[2];“共享存储”则可以更好的适配各类云存储架构;桌面版则可以在2c6g的环境完成OceanBase部署与体验。

ACMUG(中国MySQL用户组)组织的庆祝MySQL 30周年,暨ACMUG年度分享,将于23~24日于成都举行,感兴趣的可以去现场与MySQLer们面基。时间:5月23日-24日(13:00-17:50);地址:成都市武侯区吉庆四路188号IMC国际广场成都书声科技(叫叫)四楼演播厅[3]。

更新详情

阿里云

- RDS MySQL全球多活数据库(GAD)支持更多海内外地域。[4]

- RDS MySQL标准版云盘只读实例新增128核512 GB规格。[5]

- RDS PostgreSQL的大版本升级功能在蓝绿部署和本地升级等模式的基础上,新增了零停机模式[6]

- RDS SQL Server新增监控指标sqlserver.alwayson_lagsecs[7]

Azure(微软云)

- Cosmos DB支持使用 DiskANN 进行过滤向量搜索[10]

- Azure Backup 为 Azure Database for PostgreSQL 提供存储备份[11]

- Azure SQL支持JSON 索引[13]

- DocumentDB 中支持向量搜索[20]

- Cosmos DB 支持全局二级索引[22]

GCP(谷歌云)

- Spanner 现已支持 BigQuery 的跨区域联合查询[32]

- BigQuery 发布“连续查询”允许您构建长期有效、连续处理的 SQL 语句,这些语句可以实时分析、处理 BigQuery 中传入的数据并执行机器学习 (ML) 推理。[33]

- Cloud SQL for MySQL 现已支持次要版本 8.0.42[39]

- Spanner 支持创建预过滤向量索引,该索引仅索引数据库中符合特定过滤条件的行。使用预过滤向量索引可以将搜索限制为仅适用于满足过滤条件的行,从而提高近似最近邻 (ANN) 搜索器的性能和召回率 [42]

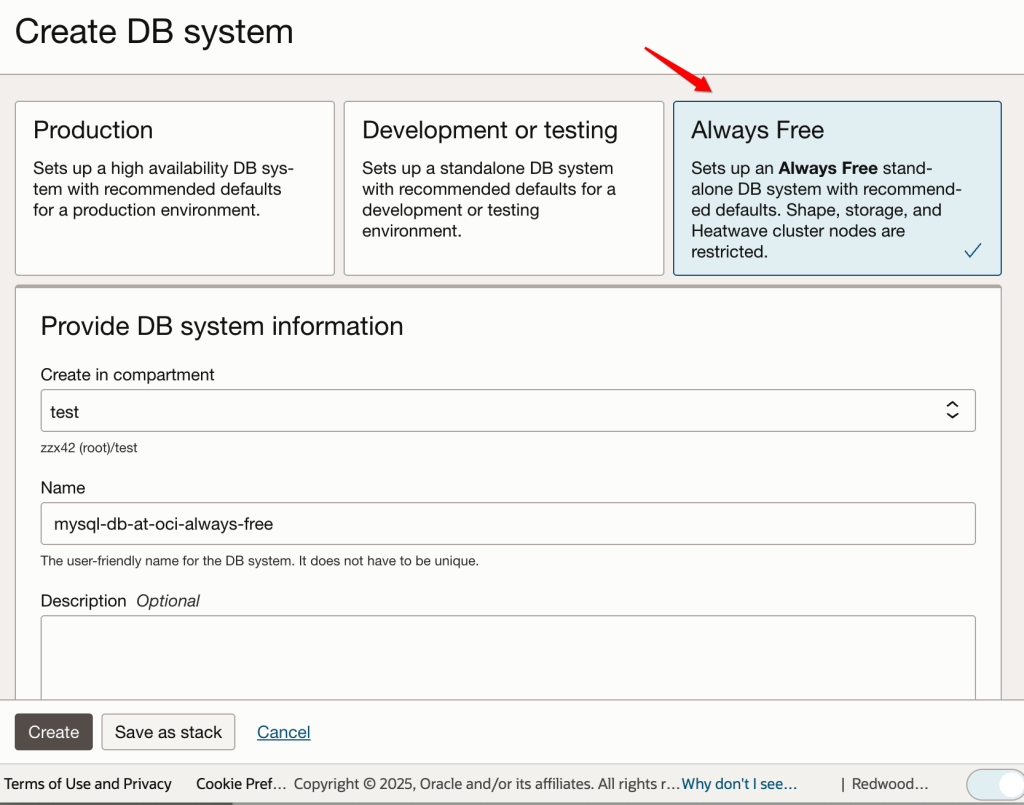

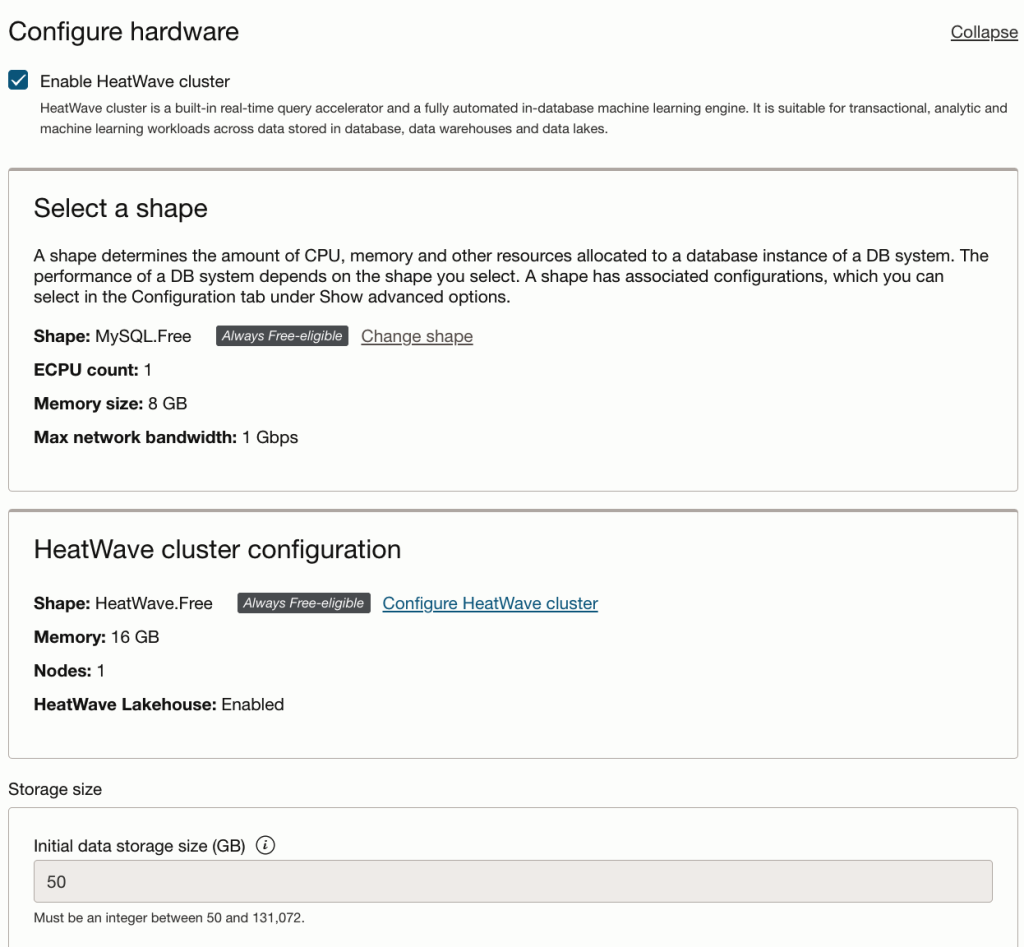

Oracle云

- HeatWave支持更完整的网络安全组功能[43]

AWS(亚马逊云)

- Aurora、RDS 支持查看开源引擎主要版本的支持日期[45]

- RDS 支持 MariaDB 10.5.29 和 10.6.22 [47]

- Aurora Global Database 引入了对最多 10 个辅助区域集群的支持[48]

- PostgreSQL 18 Beta 1 现已在 Amazon RDS 数据库预览环境中推出[59]

参考链接

- [1] https://mp.weixin.qq.com/s/Ax8Iov00ebfjsCy3Afub_Q

- [2] https://www.oceanbase.com/docs/common-oceanbase-cloud-1000000002951473

- [3] https://mp.weixin.qq.com/s/3dDU3PH9huyJytM_g3t93w

- [4] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/what-is-a-global-active-database/

- [5] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/read-only-apsaradb-rds-for-mysql-instance-types

- [6] https://help.aliyun.com/zh/rds/apsaradb-rds-for-postgresql/upgrade-the-major-engine-version-of-an-apsaradb-rds-for-postgresql-instance/

- [7] https://help.aliyun.com/zh/rds/apsaradb-rds-for-sql-server/view-standard-monitoring

- [10] https://azure.microsoft.com/updates?id=491237

- [11] https://azure.microsoft.com/updates?id=491576

- [13] https://azure.microsoft.com/updates?id=494265

- [20] https://azure.microsoft.com/updates?id=492016

- [22] https://azure.microsoft.com/updates?id=491257

- [32] https://cloud.google.com/bigquery/docs/spanner-federated-queries#cross_region_queries

- [33] https://cloud.google.com/bigquery/docs/continuous-queries-introduction

- [39] https://cloud.google.com/sql/docs/mysql/upgrade-minor-db-version

- [42] https://cloud.google.com/spanner/docs/find-approximate-nearest-neighbors#filter-vector-index

- [43] https://docs.oracle.com/iaas/releasenotes/mysql-database/heatwave-nsg.htm

- [45] https://docs.aws.amazon.com/AmazonRDS/latest/AuroraUserGuide/extended-support-viewing-support-dates.html

- [47] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MariaDB.Concepts.VersionMgmt.html

- [48] https://aws.amazon.com/about-aws/whats-new/2025/05/amazon-aurora-global-database-support-10-secondary-region-clusters

- [59] https://aws.amazon.com/about-aws/whats-new/2025/05/postgresql-18-beta-1-amazon-rds-database-preview/

- [60] https://aws.amazon.com/about-aws/whats-new/2025/05/aws-transform-net-generally-available