标题:DBaaS服务商Tessell获 $6000万融资; OceanBase开发者大会几乎5月于广州举行

重要更新

多云数据库平台服务商Tessell获 $6000万 容灾。此次融资将用于进一步扩大市场覆盖,并计划推出基于 AI 驱动的对话式数据库管理服务[1]。

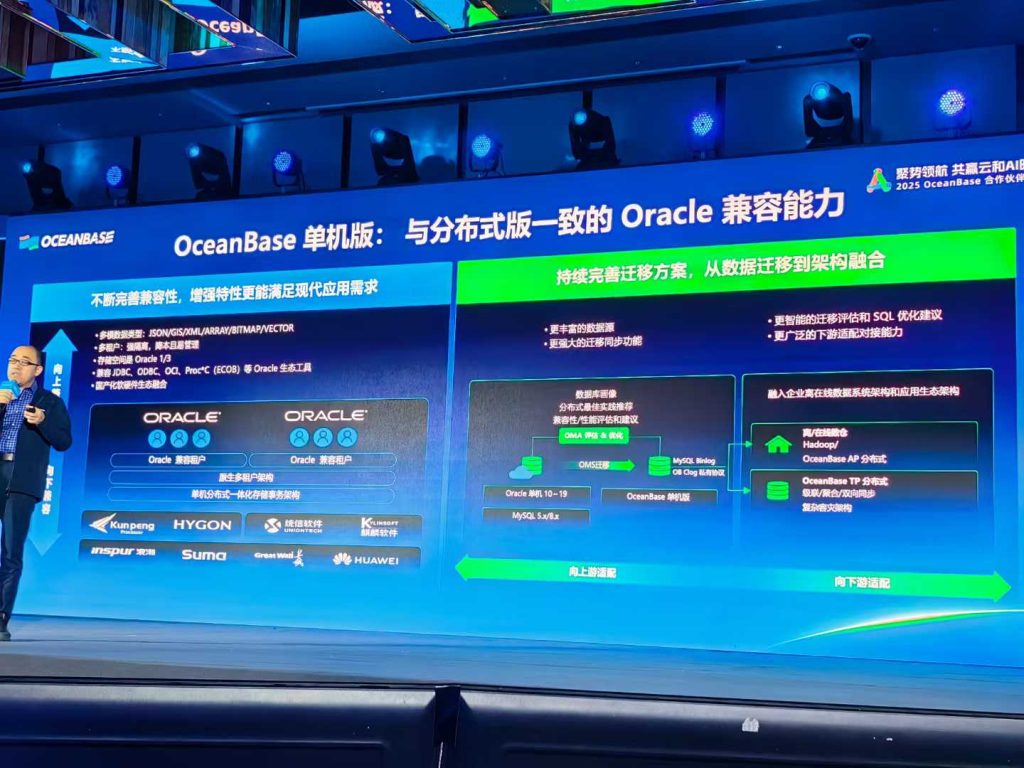

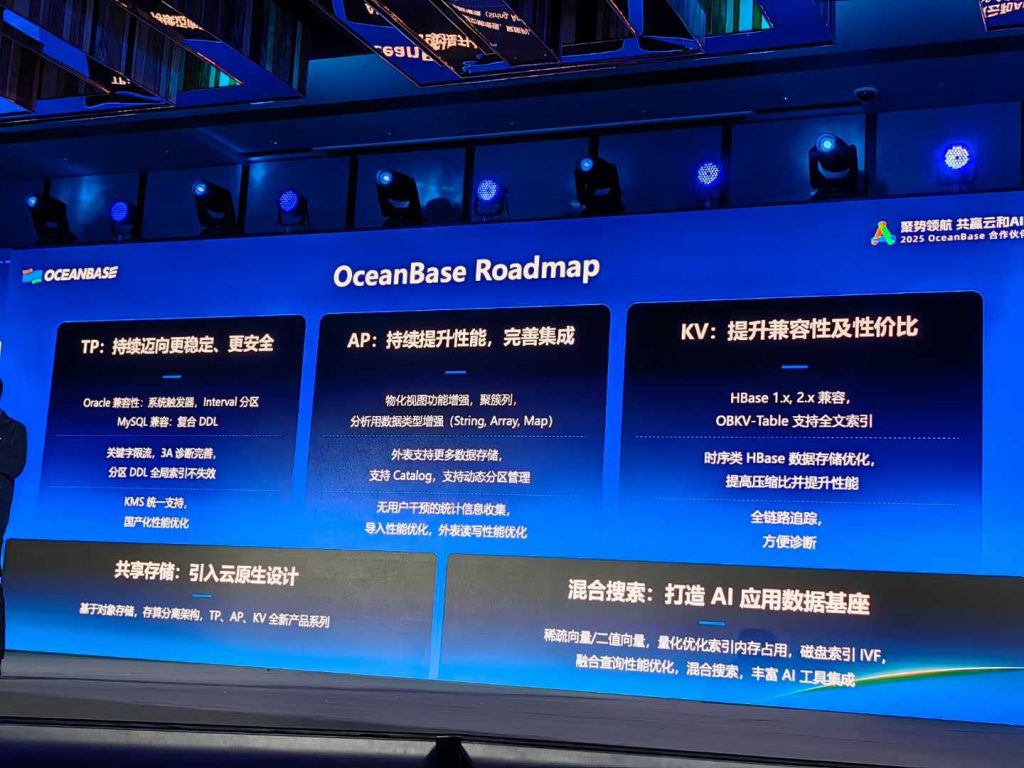

2025 OceanBase开发者大会将于5月17日广州举行。本届大会以「当 SQL 遇见 AI」为主题,会上,OceanBase 还将重磅发布面向 AI 时代的一体化产品矩阵,并分享 TP、AP、KV 及 AI 能力的最新实践成果。[2]

更新详情

阿里云

Azure(微软云)

- 适用于基于 vCore 的 Azure Cosmos DB for MongoDB 的 Power BI 连接器发布(预览版)[8]

- “I/O 性能分析”支持了Azure 虚拟机上的 SQL Server[11]

GCP(谷歌云)

- BigQuery 数据准备功能现已正式发布 (GA),它提供 Gemini 提供的 AI 驱动的数据清理、转换和数据扩充建议。支持使用 Dataform 进行可视化数据准备流程和流程调度。[14]

- Cloud SQL 现已支持Enterprise Plus 推荐器。根据您的应用程序工作负载和资源利用率,推荐器可以识别升级到 Cloud SQL Enterprise Plus 版本后性能提升情况 [16]

- BigQuery ML 现已支持以下生成式 AI 函数,可让您使用 Vertex AI Gemini 模型分析文本。[28]

- BigQuery 迁移评估现已包含对 Amazon Redshift Serverless 的支持 [34]

- 您现在可以集成 Cloud SQL for MySQL 和 Vertex AI,这允许您使用 Vertex AI 中托管的模型和生成向量嵌入[36]

- Spanner 现在支持以下 GoogleSQL JSON mutator 函数 [65]

- Spanner 向量索引和近似最近邻 (ANN) 距离函数(基于 GoogleSQL 方言)现已正式发布 [70]

- 当您创建 Cloud SQL for SQL Server 实例时,版本SQL Server 2022 Standard 现在是默认版本[71]

- Langchain 现已支持 Spanner ANN 索引[72]

Oracle云

- 性能中心中的 SQL 历史记录支持数据库的SQL执行查看 [73]

火山云(字节)

- 数据库传输服务 DTS 支持通过物理备份迁移的方式将本地数据迁移至云数据库 SQL Server 版。[76]

- DTS 在订阅 MySQL 类型的数据到消息队列 Kafka 版或专有网络 Kafka 进行消费时,支持自定义表投递在 Kafka 中的 Topic。[77]

百度云

- PegaDB支持升级小版本[79]

- PegaDB支持实例重启

AWS(亚马逊云)

- RDS for Oracle 支持 BYOL 的 m6id 和 r6id 实例类[80]

- RDS 在数据库预览环境中支持 MariaDB 11.8[81]

- Bedrock 知识库现在支持 Aurora PostgreSQL 和 MongoDB Atlas 矢量存储的混合搜索[82]

- 宣布推出 Amazon ElastiCache for Memcached 的水平自动扩展功能[84]

- Aurora PostgreSQL 支持 pgvector 0.8.0[90]

- Amazon Neptune 宣布提供 99.99% 可用性服务等级协议[96]

腾讯云

- TDSQL-C MySQL 、云数据库 MySQL 针对数据库审计进行了如下优化。审计日志文件列表,增加生成进度展示。[108]

- TDSQL-C MySQL 版发布可用区迁移功能,当集群的业务区域需要迁移时,通过可用区迁移可快速实现。[110]

- TDSQL-C MySQL 版数据库审计支持日志投递至 Ckafka 消息队列,可采集实例的数据库审计日志[111]

- 云数据库 SQL Server 监控功能更新:新增监控指标:“闩锁等待延迟”、“每秒锁超时次数”、磁盘队列长度等[113]

参考链接

- [1] https://techcrunch.com/2025/04/09/tessell-snags-60m-to-drive-data-management-at-scale/

- [2] https://mp.weixin.qq.com/s/WnlghPJXG3h8Z1E9AOzNTQ

- [5] https://help.aliyun.comhttps://help.aliyun.com/zh/polardb/polardb-for-mysql/user-guide/method-1-for-database-and-table-restoration-restore-data-from-a-backup-set

- [8] https://azure.microsoft.com/updates?id=470484

- [14] https://cloud.google.com/products#product-launch-stages

- [28] https://cloud.google.com/products#product-launch-stages

- [36] https://cloud.google.com/sql/docs/mysql/integrate-cloud-sql-with-vertex-ai

- [65] https://cloud.google.com/spanner/docs/reference/postgresql/functions-and-operators

- [70] https://cloud.google.com/spanner/docs/find-approximate-nearest-neighbors

- [72] https://github.com/googleapis/langchain-google-spanner-python/blob/main/samples/langchain_quick_start.ipynb

- [73] https://docs.oracle.com/iaas/releasenotes/database-management/perf-hub-sql-history.htm

- [76] https://www.volcengine.com/docs/6390/1471410

- [77] https://www.volcengine.com/docs/6390/133747

- [79] https://cloud.baidu.com/doc/SCS/s/fm8wrrnwi

- [80] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/Oracle.Concepts.InstanceClasses.html#Oracle.Concepts.InstanceClasses.Supported.combo

- [81] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MariaDB.Concepts.VersionMgmt.html#mariadb-preview-environment-version-11-8

- [82] https://aws.amazon.com/about-aws/whats-new/2025/04/amazon-bedrock-knowledge-bases-hybrid-search-aurora-postgresql-mongo-db-atlas-vector-stores

- [84] https://aws.amazon.com/about-aws/whats-new/2025/04/horizontal-autoscaling-amazon-elasticache-memcached/

- [90] https://aws.amazon.com/about-aws/whats-new/2025/04/pgvector-0-8-0-aurora-postgresql

- [96] https://aws.amazon.com/about-aws/whats-new/2025/04/amazon-neptune-99-99-availability-service-level-agreement

- [108] https://cloud.tencent.com/document/product/236/81406

- [110] https://cloud.tencent.com/document/product/1003/117620

- [111] https://cloud.tencent.com/document/product/1003/106892

- [113] https://cloud.tencent.com/document/product/238/70270