简单生活

-

标题:OpenAI收购实时数据搜索与分析引擎Rockset; PolarDB-X 列存索引支持Schema多版本;

重要更新

6月21日,OpenAI官方发布一则消息:宣布收购实时分析数据库开发商Rockset,以增强大模型在实时数据搜索与分析的能力,其估值约为5~10亿美金;Rockset可以对结构化数据、向量化数据、事件数据、数据湖等数据进行实时的索引构建,以提供开始的搜索与分析能力。[1]

PolarDB-X 列存索引全面支持Schema多版本,以实现原表DDL时列存索引查询时的数据实时性、一致性以及高性能。[2]

更新详情

阿里云

- RDS MySQL大版本升级新增了大版本升级前置检查功能[4]

- RDS MySQL/PostgreSQL的通用云盘版基准性能得以大幅度提升,IOPS最高提升22400,IO带宽最高提升350 MB/s。[5]

- RDS SQL Server新增支持更多性能监控项,您可以通过RDS管理控制台查看实例的标准监控数据。[8]

GCP(谷歌云)

- Cloud SQL for PostgreSQL支持原地升级到PostgreSQL 16 [16]

AWS(亚马逊云)

- Amazon RDS Oracle 支持r6i内存优化型实例 [25]

- Amazon RDS 发布5.7.44扩展支持版本5.7.44-RDS.20240529 [26]

参考链接

- [1] https://mp.weixin.qq.com/s/-_WFtIhXuOZtWxa0Asthhg

- [2] https://zhuanlan.zhihu.com/p/704192973

- [4] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/interpretation-of-rds-mysql-major-version-upgrade-check-report

- [5] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/product-function-change-general-cloud-disk-benchmark-io-performance-improvement

- [8] https://help.aliyun.com/zh/rds/apsaradb-rds-for-sql-server/view-standard-monitoring

- [16] https://cloud.google.com/sql/docs/postgres/upgrade-major-db-version-inplace

- [25 https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/Oracle.Concepts.InstanceClasses.html#Oracle.Concepts.InstanceClasses.Supported

- [26] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MySQL.Concepts.VersionMgmt.html#mysql-extended-support-releases-version-5.7.44-20240529

- [27] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MySQL.Concepts.VersionMgmt.html

-

标题:openGauss开发者大会、华为云HDC大会举行; PostgreSQL中国技术大会7月杭州开启

重要更新

openGauss Developer Day本周五于北京举行,大会聚集了相关行业专家、用户、伙伴和开发者,分享给予openGauss的联合创新成果和实践案例。[2] ; 华为云 HDC 2024本周五于东莞松山湖举行,主题演讲主要覆盖鸿蒙、AI [3] [29]

PostgreSQL中国技术大会重启,将在7月12日于杭州举办;大会以”聚焦云端创新,汇聚智慧共享”为主题,共同探讨数据库领域的发展趋势、技术创新和实践经验。

更新详情

阿里云

- RDS PostgreSQL 发布新内核版本,兼容社区16.2版本。支持插件pg_proctab(0.0.10); pgvector(0.7.0) [6]

- RDS SQL Server新增支持更多性能监控项,您可以通过RDS管理控制台查看实例的标准监控数据。[7]

- RDS SQL Server 新版售卖页面支持设置系统字符集排序规则 [8]

GCP(谷歌云)

- 数据库迁移服务支持从Oracle迁移到AlloyDB [11]

火山云(字节)

AWS(亚马逊云)

- RDS 支持最新的MySQL版本 8.0.37[26]

- RDS 最新的 MariaDB版本 10.11.8, 10.6.18, 10.5.25, 10.4.34[27]

腾讯云

- 云数据库 MySQL、TDSQL-C 发布数据库代理版本1.3.12。[28]

参考链接

- [1] https://mp.weixin.qq.com/s/ZfzqLJidkZtfTx0Vs_bl3g

- [2] https://mp.weixin.qq.com/s/I3cihudf1Q5uzUEQKXVXWg

- [3] https://mp.weixin.qq.com/s/hAnzPvp-pxIkZyDpzvZ8aQ

- [4] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/rds-mysql-serverless

- [5] https://help.aliyun.com/zh/rds/apsaradb-rds-for-mysql/configure-the-disk-encryption-feature-for-an-apsaradb-rds-for-mysql-instance

- [6] https://help.aliyun.com/zh/rds/apsaradb-rds-for-postgresql/release-notes-for-alipg

- [7] https://help.aliyun.com/zh/rds/apsaradb-rds-for-sql-server/view-standard-monitoring

- [8] https://help.aliyun.com/zh/rds/apsaradb-rds-for-sql-server/create-an-apsaradb-rds-for-sql-server-instance-1

- [11] https://cloud.google.com/database-migration/docs/oracle-to-postgresql/finalize-migration

- [26] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MySQL.Concepts.VersionMgmt.html

- [27] https://docs.aws.amazon.com/AmazonRDS/latest/UserGuide/MariaDB.Concepts.VersionMgmt.html

- [28] https://cloud.tencent.com/document/product/236/89741

- [29] https://mp.weixin.qq.com/s/HQYjFtXZPEn0sOPC_XY_Kw

-

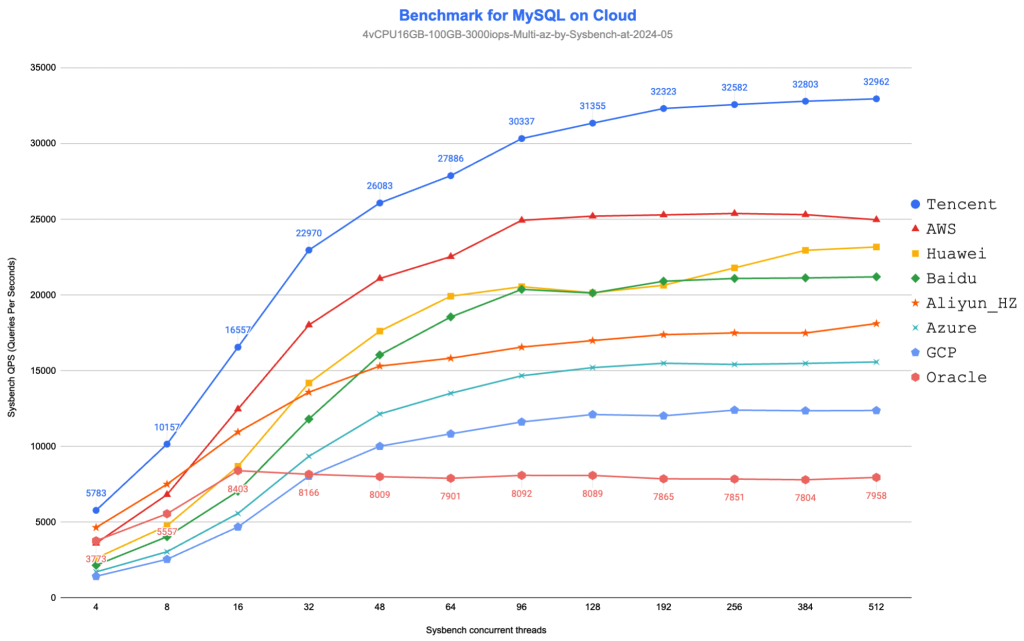

本文是一个系列文章的一部分,该系列较为完整的对各个云厂商的RDS MySQL进行了测试,包括了阿里云、腾讯云、华为云、百度云、AWS、Azure、GCP、Oracle Cloud等,最新的测试:云数据库RDS MySQL的性能。

在不同的云厂商,购买相同规格的MySQL实例(如4vCPU-16GB),获得的性能相同吗?

为了回答上面的疑问,于是就开启了我的数据库性能测试之旅。这是第二次测试,上一次是在2023年12月(参考:云数据库(RDS MySQL)性能深度测评与对比)。

性能测试结果与概述